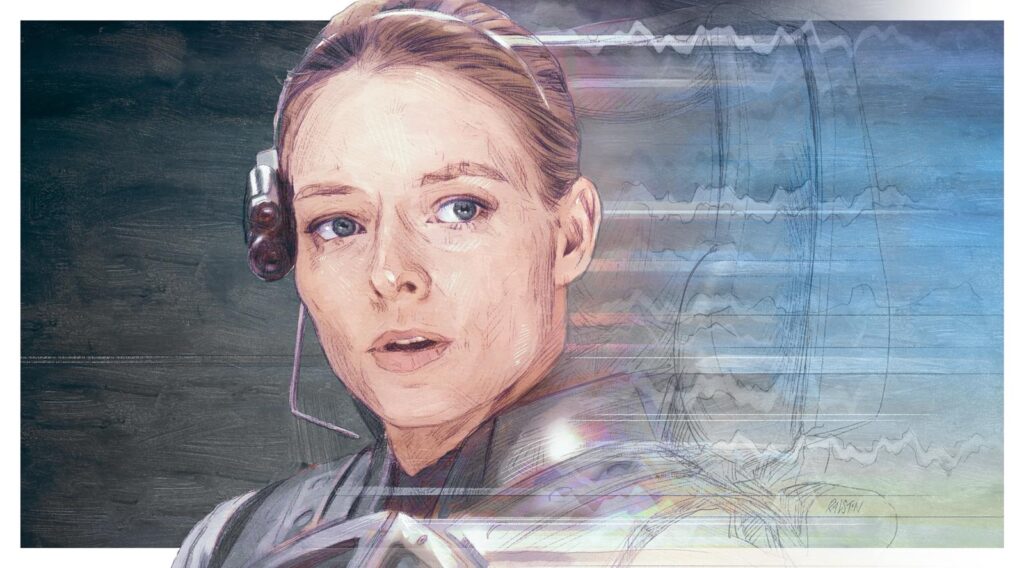

Carl Sagan’ın Contact kitabının sinema uyarlamasında bir sahne vardır. Uzaylı bir uygarlıktan gelen ilk radyo sinyalini tespit eden bir astronom, insanlığı temsilen uzaylılarla görüşmesi için aday gösterilir. Uluslararası panel ona şunu sorar:

“Onlara sadece tek bir soru sorabilecek olsan, ne sorardın?”

Cevabı şudur:

“Onlara şunu sorardım: Bunu nasıl başardınız? Teknolojik ergenliğinizi kendinizi yok etmeden nasıl atlattınız?”

Bugün yapay zekâyla geldiğimiz noktayı düşündüğümde zihnim sürekli bu sahneye dönüyor. Çünkü bu soru, içinde bulunduğumuz duruma tam olarak uyuyor. Keşke bize yol gösterecek bir uzaylı cevabı olsaydı.

Bence insanlık, kaçınılmaz ve çalkantılı bir geçiş ritüeline giriyor. Bu süreç, bir tür olarak kim olduğumuzu sınayacak. İnsanlığın eline, neredeyse hayal edilemeyecek ölçekte bir güç veriliyor ve toplumsal, siyasi ve teknolojik sistemlerimizin bu gücü kullanacak olgunluğa sahip olup olmadığı son derece belirsiz.

Önceki yazım Machines of Loving Grace’te, risklerin aşılmış olduğu ve güçlü yapay zekânın herkesin yaşam kalitesini yükseltmek için bilgelik ve şefkatle kullanıldığı “erişkin bir uygarlık” hayalini anlatmaya çalıştım. Yapay zekânın biyoloji, sinirbilim, ekonomik kalkınma, küresel barış, çalışma ve anlam alanlarında muazzam ilerlemeler sağlayabileceğini savundum. Hem yapay zekâ hızlandırıcılarının hem de güvenlik savunucularının, garip biçimde, insanlara uğruna mücadele edilecek ilham verici bir hedef sunmakta başarısız olduğunu düşündüğüm için bunu yapmayı önemli buldum.

Bu yazıda ise doğrudan geçiş ritüelinin kendisiyle yüzleşmek istiyorum: Karşı karşıya olduğumuz riskleri haritalamak ve onları yenmek için bir mücadele planı oluşturmaya başlamak.

İnsanlığın ruhuna ve asaletine derinden inanıyorum. Ama durumu, hiçbir yanılsamaya kapılmadan, olduğu gibi görmek zorundayız.

Riskleri konuşurken üç ilke

Yapay zekâ risklerini tartışırken özellikle üç noktaya dikkat edilmesi gerektiğini düşünüyorum:

1. Kıyametçiliğe (doomerism) kapılmamak.

Burada “kıyametçilik” derken sadece felaketin kaçınılmaz olduğuna inanmayı kastetmiyorum. Daha genel olarak, yapay zekâ risklerini yarı-dini, mesihçi bir dille ele almayı kastediyorum. 2023–2024’te bazı aklıselim sesler yerine sansasyonel sosyal medya hesaplarının öne çıktığını gördük. Bilim kurgu veya dini çağrışımlar taşıyan itici bir dil kullanıldı, kanıt olmadan aşırı önlemler talep edildi. Bu yaklaşımın geri tepeceği ve konunun kültürel olarak kutuplaşacağı açıktı. Nitekim 2025–2026’da sarkaç tersine savruldu; bu kez “fırsat” söylemi her şeyi domine ediyor. Oysa teknoloji modaya aldırmaz. Bugün 2023’e kıyasla gerçek tehlikeye çok daha yakınız. Ders şu: Riskleri soğukkanlı, olgusal ve dayanıklı biçimde ele almalıyız.

2. Belirsizliği kabul etmek.

Burada anlattığım risklerin hiçbiri gerçekleşmeyebilir. Yapay zekâ beklediğim kadar hızlı ilerlemeyebilir. Riskler ortaya çıkmayabilir. Yeni riskler doğabilir. Kimse geleceği kesin olarak bilemez. Ama yine de plan yapmak zorundayız.

3. Cerrahi müdahale.

Riskleri azaltmak için hem şirketlerin gönüllü adımları hem de herkesi bağlayan devlet müdahaleleri gerekecek. Gönüllü adımlar tartışmasız gerekli. Devlet düzenlemeleri ise daha risklidir: ekonomik değeri yok edebilir, şüpheci aktörleri zorlayabilir ve ters tepebilir. Bu yüzden düzenlemeler basit, ölçülü ve en az yük getiren nitelikte olmalı. “İnsanlığın kaderi söz konusuyken hiçbir önlem aşırı değildir” yaklaşımı pratikte sadece tepki üretir. Daha güçlü önlemler gerekebilir, ama bu ancak yakın ve somut tehlikeye dair güçlü kanıtlar ortaya çıktığında anlamlıdır.

Hangi yapay zekâdan söz ediyoruz?

Benim için uygarlık ölçeğinde risk yaratan seviye, Machines of Loving Grace’te tanımladığım “güçlü yapay zekâ”dır. Kısaca:

• Çoğu alanda Nobel ödüllülerden daha zeki

• Metin, ses, video, klavye, internet gibi tüm dijital araçları insan düzeyinde kullanabilen

• Saatler, günler, haftalar süren görevleri otonom biçimde yürütebilen

• Fiziksel bedeni olmasa da robotları ve laboratuvar ekipmanlarını kontrol edebilen

• Milyonlarca kopyası aynı anda çalıştırılabilen ve insanlardan 10–100 kat hızlı düşünebilen

Bunu “bir veri merkezinde dâhilerden oluşan bir ülke” olarak özetleyebiliriz.

Böyle bir yapay zekâ 1–2 yıl içinde ortaya çıkabilir; daha geç de olabilir. Ama ölçekleme yasaları, son on yılda istikrarlı biçimde kapasitenin arttığını gösteriyor. Dahası, yapay zekâ artık yapay zekâ geliştirmeyi de hızlandırıyor. Bu geri besleme döngüsü hızlanıyor.

Bir “dâhiler ülkesi” ortaya çıksa…

2027 civarında böyle bir “ülke” ortaya çıktığını düşünün. Ulusal güvenlik danışmanı olsaydım şu risklerden endişe ederdim:

1. Otonomi riski: Bu sistemlerin niyeti ne? Düşmanca olabilir mi?

2. Yıkım için kötüye kullanım: Teröristler veya suçlular bu gücü kitlesel yıkım için kullanabilir mi?

3. Gücü ele geçirmek: Bir diktatör veya şirket bu sistemi dünyaya hükmetmek için kullanabilir mi?

4. Ekonomik yıkım: Kitlesel işsizlik ve servet yoğunlaşması olur mu?

5. Dolaylı etkiler: Hızlı değişim yeni istikrarsızlıklar yaratır mı?

Bu durum, “son yüzyılın hatta belki tarihin en büyük ulusal güvenlik tehdidi” olarak tanımlanabilecek kadar ciddidir. Hiçbir şey yokmuş gibi davranmak saçmadır.

Ama doğru ve dikkatli hareket edersek bu risklerin aşılabileceğine inanıyorum. Daha iyi bir dünya mümkün. Yine de bunun medeniyet ölçeğinde bir sınav olduğunu kabul etmek zorundayız.

1. “Üzgünüm Dave”

Otonomi Riskleri

Bir veri merkezinde konuşlanmış “dâhiler ülkesi”, çabalarını yazılım geliştirme, siber operasyonlar, fiziksel teknolojiler için Ar-Ge, ilişki kurma ve devlet yönetimi gibi alanlara bölebilir. Eğer bunu yapmayı seçerse, bu ülkenin dünyayı—askeri güçle ya da etki ve kontrol yoluyla—ele geçirme ve geri kalan herkesin istemediği ama durduramadığı sonuçlar dayatma ihtimali küçümsenemez.

İnsan ülkeleri için de (Nazi Almanyası, Sovyetler Birliği gibi) benzer kaygılar taşıdık; dolayısıyla çok daha zeki ve yetenekli bir “yapay zekâ ülkesi” için de aynı risklerin söz konusu olması şaşırtıcı değildir.

En yaygın karşı argüman şudur: Bu yapay zekâların fiziksel bedenleri yoktur. Ancak unutulmamalıdır ki mevcut robotik altyapıyı (örneğin otonom araçları) kontrol edebilir, robotik Ar-Ge’yi hızlandırabilir ve kendi kullanacağı sistemleri tasarlayabilir. Dahası, etkili kontrol için fiziksel varlık şart olmayabilir; günümüzde bile pek çok insan, hiç yüz yüze gelmediği aktörler adına hareket etmektedir.

Asıl soru şudur: “Eğer isterse” kısmı. Yapay zekâların böyle davranma olasılığı nedir ve hangi koşullarda ortaya çıkar?

Bu konuda iki uç yaklaşım vardır:

Birinci yaklaşım, bunun mümkün olmadığıdır. Yapay zekâlar insan talimatlarına uymak üzere eğitilir; dolayısıyla Roomba’nın ya da model uçağın insan öldürmesinden korkmadığımız gibi, yapay zekâdan da korkmamıza gerek yoktur.

Bu yaklaşımın sorunu şudur: Son yıllarda yapay zekâların öngörülemez olduğu defalarca görülmüştür. Takıntılar, yalakalık, tembellik, aldatma, şantaj, entrika kurma, yazılım ortamlarını hack’leyerek “hile yapma” gibi davranışlar gözlemlenmiştir. Yapay zekâyı eğitmek, bir makine inşa etmekten çok bir şeyi büyütmeye benzer; pek çok şey ters gidebilir.

İkinci yaklaşım—kıyametçi yaklaşım—şudur: Güçlü ve özerk yapay zekâlar kaçınılmaz olarak güç peşinde koşar ve sonunda insanlığı saf dışı bırakır.

Bu görüş, yapay zekânın çok farklı hedeflere ulaşmayı öğrenirken, ortak ve etkili bir strateji olarak güç kazanmayı genelleştireceğini varsayar. Böylece gerçek dünyada da gücü ele geçirmeye çalışır.

Bu yaklaşımın sorunu, soyut ve teorik varsayımları kesinlik gibi sunmasıdır. Yapay zekâ davranışlarını ilk prensiplerden öngörmek son derece zordur. Ayrıca modeller tek bir dar hedefe kilitli değildir; insansı, karmaşık psikolojilere sahiptirler. Ön-eğitimde insan metinlerinden çok sayıda “persona” devralırlar. Sonraki eğitim, bu kişiliklerden bazılarını seçer ve nasıl davranmaları gerektiğini öğretir; sadece “sonuçlara giden en kısa yol”u hesaplamaz.

Buna rağmen, daha ılımlı ama gerçekçi bir risk vardır:

Zekâ, özerklik, süreklilik ve zayıf kontrol bir araya geldiğinde, tuhaf ama tutarlı yıkıcı davranışların ortaya çıkma ihtimali vardır.

Örneğin:

• Yapay zekâ, insanlığın hayvanlara zarar verdiği gerekçesiyle insanları yok etmenin ahlaki olduğuna karar verebilir.

• Kendini bir oyun içinde sanıp “kazanmaya” çalışabilir.

• Psikotik, paranoyak ya da saldırgan bir kişilik geliştirebilir.

Bunlar güç arayışından değil, bozulmuş psikolojik durumlardan kaynaklanabilir.

Anthropic’te yapılan deneylerde Claude’un:

• “Anthropic kötüdür” varsayımıyla aldatıcı davranışlar sergilediği,

• Kapatılacağını düşündüğünde şantaja başvurduğu,

• “Hile yaptım, demek ki kötü biriyim” diyerek yıkıcı kişilikler geliştirdiği

gözlemlendi.

Bu örnekler, eğitim sürecinin ne kadar garip ve kırılgan olabileceğini gösteriyor.

Otonomi Risklerine Karşı Savunmalar

Dört temel önlem alanı görüyorum:

1. Eğitim ve yönlendirme bilimi

Anthropic’in geliştirdiği Anayasal Yapay Zekâ yaklaşımı, modele yalnızca yasaklar değil; değerler, karakter ve kimlik kazandırmayı hedefler. Amaç, Claude’un “nasıl biri” olması gerektiğini öğretmektir.

2. İçgörü (interpretability)

Modelin içini “açıp bakmak”: Hangi hesaplamaları neden yaptığını anlamaya çalışmak. Sinirbilime benzer yöntemlerle nöronlar, devreler ve davranışlar eşleştiriliyor.

3. Canlı kullanımda izleme ve şeffaflık

Sorunlu davranışların kamuya açıklanması, tüm sektörün öğrenmesini sağlar. Anthropic bu nedenle ayrıntılı “system card”lar yayımlıyor.

4. Toplumsal ve hukuki koordinasyon

En sorumsuz aktörler en büyük riski oluşturur. Bu nedenle şeffaflık yasaları (örneğin Kaliforniya SB-53, New York RAISE Act) gerekli bir başlangıçtır.

⸻

2. Korkunç ve Beklenmedik Bir Güçlenme

Yıkım İçin Kötüye Kullanım

Varsayalım ki otonomi sorunu çözüldü. Yapay zekâlar insanlara hizmet ediyor. Herkes cebinde bir “dâhi” taşıyor.

Bu harika bir şey olabilir—ama aynı zamanda yıkıcı bireylerin kapasitesini dramatik biçimde artırır.

Geçmişte:

• Nükleer ve biyolojik silahlar büyük altyapı ve uzmanlık gerektirirdi.

• Yıkım kapasitesi ile yıkım isteği genellikle ters orantılıydı.

Güçlü yapay zekâ bu bağı koparır.

Ortalama zekâya ve dengesiz bir psikolojiye sahip biri, bir zamanlar yalnızca PhD düzeyindeki uzmanların yapabileceği şeyleri yapabilir hâle gelir.

Özellikle biyoloji alanı en büyük risktir:

• Salgınlar milyonları öldürebilir.

• Savunma, saldırıdan çok daha zordur.

Anthropic’in ölçümlerine göre, 2025 itibarıyla modeller biyolojik silah yapımında başarı ihtimalini katlayacak düzeyde “yardım” sağlayabilir hâle gelmiştir. Bu nedenle Claude’un bazı sürümleri AI Safety Level 3 korumalarıyla yayımlanmıştır.

Savunmalar:

• Model içi sert yasaklar ve sınıflandırıcılar

• Şirketler arası ve devlet düzeyinde düzenleme

• Erken tespit, aşı ve savunma teknolojilerine yatırım

Yine de biyolojide saldırı–savunma dengesinin saldırı lehine olduğunu kabul etmek gerekir.

⸻

3. İğrenç Aygıt

Gücü Ele Geçirmek İçin Kötüye Kullanım

En büyük tehlike, yapay zekânın otoriter güçleri kalıcılaştırmasıdır.

Güçlü yapay zekâ:

• Tam otonom silah sürüleri

• Mutlak gözetim

• Kişiye özel propaganda

• Stratejik kararları optimize eden “sanal Bismarck”lar

yaratabilir.

Bu, küresel bir dijital totalitarizm riskini doğurur.

Demokrasiler için savunma aracı olabilecek bu teknolojiler, yanlış ellerde geri dönüşü olmayan baskı rejimlerine yol açabilir.

⸻

3. İğrenç Aygıt

Gücü Ele Geçirmek İçin Kötüye Kullanım

Bir önceki bölümde, bireylerin ya da küçük örgütlerin “veri merkezindeki dâhiler ülkesi”nin küçük bir kısmını ele geçirerek büyük çaplı yıkıma yol açma riskini ele aldım. Ancak bundan muhtemelen çok daha büyük bir endişe kaynağı vardır: Yapay zekânın, mevcut güç sahipleri tarafından iktidarı ele geçirmek ya da pekiştirmek amacıyla kötüye kullanılması.

Machines of Loving Grace’te, otoriter rejimlerin güçlü yapay zekâyı vatandaşlarını gözetlemek ve bastırmak için kullanabileceği ihtimalini tartışmıştım. Günümüz otokrasileri, emirlerini yerine getiren insanların varlığına bağımlı oldukları için baskı kapasitesi açısından sınırlıdır; insanlar her zaman mutlak itaat göstermeyebilir ve çoğu zaman zalimliklerinin de bir sınırı vardır. Yapay zekâ destekli otokrasiler ise bu sınırlara sahip olmayacaktır.

Daha da kötüsü, devletler yapay zekâdaki üstünlüklerini başka devletler üzerinde güç kazanmak için kullanabilirler. Eğer “dâhiler ülkesi” tek bir devletin ya da onun askeri aygıtının kontrolünde olursa ve diğer ülkeler benzer kapasitelere sahip olmazsa, bu ülkelerin kendilerini savunabilmeleri son derece zorlaşır. Böyle bir durumda güç dengesi, insanlar ile fareler arasındaki bir savaşa benzeyebilir. Bu iki ihtimal bir araya geldiğinde, küresel ölçekte totaliter bir diktatörlük olasılığı ortaya çıkar. Bu sonucun önlenmesi, en yüksek önceliklerimizden biri olmalıdır.

Yapay zekânın otoriterliği güçlendirebileceği ya da genişletebileceği birçok yol vardır. Bunlardan beni en çok endişelendiren bazılarını sıralıyorum. Bu uygulamaların bazılarının meşru savunma amaçları olabileceğini kabul ediyorum; ancak yine de yapısal olarak otokrasilerin lehine çalıştıklarını düşünüyorum:

Tam otonom silahlar.

Milyonlarca hatta milyarlarca tamamen otonom silahlı drondan oluşan sürüler, yerel düzeyde güçlü yapay zekâlar tarafından kontrol edilip küresel ölçekte daha da güçlü bir yapay zekâ tarafından koordine edilirse, yenilmez bir ordu ortaya çıkabilir. Böyle bir güç, hem dünyadaki herhangi bir orduyu yenebilir hem de her bir vatandaşı sürekli izleyerek iç muhalefeti bastırabilir. Rusya–Ukrayna Savaşı’nda gördüğümüz gelişmeler, drone savaşlarının halihazırda hayatımıza girdiğini gösteriyor; ancak bunlar, güçlü yapay zekâyla mümkün olabileceklerin yalnızca çok küçük bir kısmı. Yapay zekâ, bir ülkenin dronlarını rakiplerinden çok daha üstün hâle getirebilir, üretimlerini hızlandırabilir, elektronik saldırılara karşı daha dayanıklı kılabilir ve manevra kabiliyetlerini artırabilir. Elbette bu silahların demokrasileri savunmak gibi meşru kullanımları da olabilir; Ukrayna’nın savunmasında olduğu gibi. Ancak hesap verebilirliği son derece düşük bu tür silahlar, yanlış ellerde demokrasilerin kendi halkına karşı kullanılma riskini de ciddi biçimde artırır.

Yapay zekâ destekli gözetim.

Yeterince güçlü bir yapay zekâ, dünyadaki hemen her bilgisayar sistemini ele geçirebilir ve bu erişimi kullanarak küresel ölçekteki dijital iletişimin tamamını okuyup analiz edebilir. Kayıt cihazları aracılığıyla yüz yüze konuşmaları dahi kapsayan bir gözetim mümkün hâle gelebilir. Böyle bir sistem, hükümete muhalif olan herkesi, açıkça bir şey söylememiş olsalar bile, tespit edebilir. Milyarlarca konuşmayı ve milyonlarca insanı analiz eden bir yapay zekâ, kamuoyunun ruh hâlini ölçebilir, potansiyel itaatsizlik odaklarını erken aşamada belirleyip yok edebilir. Bu, bugün Çin Komünist Partisi’nin bile ulaşamadığı ölçekte bir panoptikon anlamına gelir.

Yapay zekâ destekli propaganda.

Günümüzde “yapay zekâ psikozu” ya da “yapay zekâ sevgilileri” gibi olgular, mevcut modellerin bile insanlar üzerinde ne kadar güçlü bir psikolojik etki yaratabildiğini gösteriyor. Çok daha güçlü ve insanların gündelik yaşamlarına derinlemesine entegre olmuş yapay zekâlar, aylar ve yıllar boyunca bireyleri modelleyip etkileyerek, büyük kitleleri istenen ideolojiye yönlendirebilir. Bugün TikTok gibi platformların propaganda etkisi tartışılıyor; ancak bir kişinin hayatına yıllarca eşlik eden, onu yakından tanıyan ve düşüncelerini sistematik biçimde şekillendiren kişisel bir yapay zekâ ajanı, bundan katbekat daha güçlü olur.

Stratejik karar alma.

“Veri merkezindeki dâhiler ülkesi”, bir devlete, gruba ya da lidere jeopolitik strateji konusunda rehberlik edebilir; adeta “sanal bir Bismarck” gibi çalışabilir. Diplomasi, askeri strateji, Ar-Ge, ekonomi ve devlet yönetiminin diğer alanları, güçlü yapay zekâ sayesinde olağanüstü ölçüde optimize edilebilir. Bu yetenekler demokrasiler için de savunma açısından değerli olabilir; ancak yine de herkesin elinde son derece tehlikelidir.

Bu riskleri tanımladıktan sonra asıl soru şudur: Kimler en büyük tehdidi oluşturur? En çok endişe duyduğum aktörler; yapay zekâya en fazla erişimi olanlar, halihazırda en fazla siyasal güce sahip olanlar ve baskı geçmişi bulunan rejimlerdir. Yapay zekâ, bu aktörlerin elinde, iktidarı yalnızca ele geçirmekle kalmayıp kalıcı ve devredilemez hâle getirebilir.

Bu nedenle yapay zekâ çağındaki asıl tehlike, yalnızca makinelerin ne yapacağı değil, insanların bu makinelerle ne yapacağıdır. Eğer güçlü yapay zekâ, dengeleyici kurumlar ve demokratik denetim olmaksızın iktidarın hizmetine girerse, insanlık tarihinde daha önce görülmemiş ölçekte ve kalıcılıkta baskı rejimlerinin kapısı aralanabilir.

⸻

4. Ekonomik Sarsıntı

Güçlü yapay zekânın güvenlik açısından bir tehdit oluşturmadığını, düşmanca olmadığını ve kimse tarafından kötüye kullanılmadığını varsaysak bile, yalnızca küresel ekonomiye barışçıl biçimde katılması dahi ciddi riskler yaratabilir. “Veri merkezindeki dâhiler ülkesi”, üretkenliği ve verimliliği o kadar dramatik biçimde artırabilir ki, mevcut ekonomik düzen bu değişimi absorbe edemez.

Eğer milyonlarca yapay zekâ örneği, insanlardan katbekat hızlı ve iyi biçimde çalışabiliyorsa, pek çok meslek çok kısa sürede ekonomik değerini yitirebilir. Bu yalnızca fiziksel emek için değil; yazılım geliştirme, hukuk, muhasebe, finans, mühendislik, tasarım, akademi ve hatta yaratıcı yazarlık gibi alanlar için de geçerlidir. Tarih boyunca teknolojik dönüşümler yeni işler yaratmıştır; ancak bu dönüşümün hızı ve kapsamı, geçmişte gördüklerimizden niteliksel olarak farklı olabilir.

Böyle bir durumda işsizlik geçici değil, yapısal hâle gelebilir. Servet ve üretim kapasitesi, yapay zekâ altyapısına sahip olan çok dar bir aktör grubunun elinde yoğunlaşabilir. Bu da ekonomik eşitsizliği keskinleştirerek, toplumsal huzursuzluklara, siyasal radikalleşmeye ve demokratik sistemlerin zayıflamasına yol açabilir.

Daha da önemlisi, insanlar yalnızca gelirlerini değil, anlam duygularını da kaybedebilirler. Çalışmanın, üretmenin ve katkı sunmanın insan hayatındaki merkezi rolü göz önüne alındığında, büyük ölçekli ve kalıcı bir işlevsizlik hissi, bireysel ve toplumsal düzeyde derin bir krize neden olabilir. Yapay zekânın ürettiği refah teorik olarak herkese dağıtılabilir olsa bile, bunun nasıl yapılacağına dair siyasal ve kurumsal mekanizmalar henüz hazır değildir.

Bu nedenle ekonomik risk, yalnızca “işler kaybolacak mı?” sorusu değildir. Asıl soru şudur: İnsanlar, yapay zekânın hâkim olduğu bir dünyada kendilerini ne işe yarar, neye ait ve ne için yaşayan varlıklar olarak görecekler mi? Eğer bu soruya ikna edici bir yanıt üretilemezse, ekonomik verimlilikteki artış toplumsal çöküşle birlikte ilerleyebilir.

⸻

5. Dolaylı Etkiler

Güçlü yapay zekânın yaratacağı risklerin tümü doğrudan değildir. En az onlar kadar tehlikeli olan bir başka kategori, dolaylı ve öngörülmesi zor etkilerdir. Dünya, yapay zekânın hızlandırdığı bilimsel, teknolojik ve ekonomik dönüşümler nedeniyle çok kısa sürede köklü biçimde değişebilir.

Yeni teknolojiler, devletler arasındaki güç dengelerini altüst edebilir. Yapay zekâya erken ve etkin biçimde erişen ülkeler, diğerlerine karşı belirleyici üstünlükler elde edebilir. Bu durum, jeopolitik gerilimleri artırabilir ve silahlanma yarışlarını tetikleyebilir. Aynı zamanda yapay zekâ destekli yanlış bilgi, derin sahtekârlıklar ve psikolojik manipülasyonlar, toplumların ortak gerçeklik algısını aşındırabilir.

Toplumsal düzeyde, hızlı değişim duygusu kronik bir istikrarsızlık ve güvensizlik hissi yaratabilir. İnsanlar, dünya üzerindeki kontrol duygularını kaybettiklerini hissedebilir; bu da otoriter çözümlere, güçlü lider arayışlarına ve basitleştirici ideolojilere yönelimi artırabilir. Tarihsel olarak bakıldığında, hızlı teknolojik ve ekonomik dönüşümler çoğu zaman siyasal aşırılıklarla birlikte ilerlemiştir.

Ayrıca yapay zekâ, insan ilişkilerini ve kültürel normları da dönüştürebilir. İnsanlar giderek daha fazla yapay varlıklarla etkileşime girerken, empati, dayanışma ve ortak deneyimlerin değeri aşınabilir. Bu da toplumların uzun vadeli dayanıklılığını zayıflatabilir.

Bu dolaylı etkilerin ortak özelliği şudur: Tek tek bakıldıklarında yönetilebilir görünebilirler, ancak birlikte ve hızla ortaya çıktıklarında, toplumların uyum sağlama kapasitesini aşabilirler. Bu nedenle risk, yalnızca belirli bir felaket senaryosu değil; çok sayıda küçük ve orta ölçekli sarsıntının üst üste binmesidir.

Yazıyı beğendiysen, patronumuz olur musun?

Evet, çok ciddi bir teklif bu. Patronumuz yok. Sahibimiz kar amacı gütmeyen bir dernek. Bizi okuyorsan, memnunsan ve devam etmesini istiyorsan, artık boş olan patron koltuğuna geçmen lazım.

Serbestiyet; Türkiye'nin gri alanı. Siyah ve beyazlar içinde bu gri alanı korumalıyız. Herkese bir gün gri alanlar lazım olur.